5分鐘了解 OpenAI ChatGPT、人工智能技術

OpenAI ChatGPT vs Google BARD (2023.02.27)

- Google的 BARD 目前還是實驗性的 AI 對話服務

- Open AI 的 ChatGPT 已開始大規模試用

- BARD 和 ChatGPT 類似,都可以模擬人類的對話,並提供有用的回答

- Google 的 BARD 是基於 LaMDA 技術開發,它會從網路上獲取所有的資訊

- OpenAI 的 ChatGPT 則是基於 GPT-3.5 技術,目前還不會從網路上獲取資訊

- 兩者都是基於生成式人工智能/人工智慧技術 (Generative AI) 的 Transformer 神經網路架構的大型語言模型 (LLLM, Large Language Model)

- ChatGPT 模型數量高達 1750 億個,有 45T 的巨量資料,部署了 1 萬顆 GPU 繪圖運算處理器進行機器學習訓練

- OpenAI ChatGPT 模型主要目標在產成自然語言文本、語言理解、文本分類

- Google LaMDA 模型主要目標在提高資訊檢索效果

GPT-3.5 vs GPT-3.0 vs GPT-2.0

- GPT-3.5 是 OpenAI 自己內部的版號,為 GPT-3.0 的增強版

- GPT-3.0 為基於 GPT-2.0 基礎進行改善、擴展的模型,有更多參數、更強性能,能生成更位流暢、準確、具有邏輯性的語言輸出

- GPT-3.0 較 GPT-2.0 增加數學運算、編碼、解碼,更為穩定可靠

ChatGPT 跟 BARD 採用的 AI 模型架構一樣嗎?

- ChatGPT 主要目的在生成自然語言文本、語言理解、文本分類

- BARD 主要目的在提高資訊檢索效果,而非產生文本

- 兩者都是採用 Transformer 架構來處理自然語言,但目標任務和應用場景不同

- ChatGPT

- OpenAI 開發,採用多層 Transformer 編碼器跟解碼器架構

- 使用自然回歸模型,對大規模文本數據進行預訓練

- 主要目標在產成自然語言文本、語言理解、文本分類

- BARD (Billion-scale Autoregressive Retrieval Dataset)

- 是 Google 提出的一個新的自然語言處理數據集

- 目的在通過大規模文本數據訓練 Transformer 模型,提高資訊檢索任務性能

- 與 ChatGPT 同樣採用自然回歸模型

- 主要目標在提高資訊檢索效果

何為生成式人工智慧 Generative AI

生成式人工智慧是一種人工智能演算法,透過既有內容,例如文章,音頻文件或影像,創建新的內容,允許計算機運用輸入資料為基礎,然後生成相似的內容。

與過去的人工智慧技術的不同之處在於,生成式人工智能不僅能從數據中學習和分類,還能創造出全新、完全原創、真實的內容,這些內容與訓練數據相似,但不是複製。

|

| Source: Visualcapitalist |

Transformer 模型是什麼

- Transformer 模型是一種神經網路架構,主要用於自然語言處理 (NLP, Natural Language Procession)

- 最初由 Google 研究團隊在 2017 年提出,主要特點在沒有使用傳統的循環神經網路 (RNN)、卷積神經網路 (CNN)

- Transformer 採用自注意力機制 (Self-Attention) 來建立序列信息,因此能更好的處理長序列輸入,並能夠平行運算、加速訓練速度

- Transformer 模型包含兩個主要組件,每個組件都由多層組成,每個層包含多頭自注意力機制與前饋神經網路

- 編碼器

- 解碼器

- Transformer 在自然語言處理 NLP 的優勢,在於能有效處理長序列輸入 (較長的使用者輸入),因為能平行運算所以訓練效率、預測效果都較好,在文本生成、語言理解、機器翻譯的效果較佳

Transformer 模型應用

|

| Source: Nvidia |

RNN 循環神經網路模型是什麼

- RNN: Recurrent Neural Networks

- RNN 是一種序列模型,能夠自然的處理輸入的時間關係

- RNN 的計算是順序執行的,不利於平行計算

- RNN 容易產生梯度消失跟無法收斂的問題

|

| Source: Quora.com |

CNN 卷積神經網路模型是什麼

- CNN: Convolutional Neural Networks

- CNN 模型主要應用在圖像處理領域

- CNN 對於序列輸入處理,需要先將序列轉換為圖片,或是固定長度的向量表示

- CNN 在自然語言處理 NLP 上表現並不理想

Convolutional Neural Networks (CNN)

|

| Source: Analytics Vidhya |

Tesla 自動駕駛採用了那些 AI 模型

- Tesla 的自動駕駛主要就是使用了 CNN、RNN 兩種深度學習模型

- CNN 用於處理視覺訊息,從相機、雷達等傳感器獲取的原始數據提取特徵,識別道路、車道、交通號誌、其他車輛等,以進行行車、障礙物檢測等任務

- RNN 模型則用於處理車輛傳感器蒐集到的序列數據,例如車速、加速度、方向盤轉動角度等訊息,用來預測車輛行駛狀態、行駛意圖,幫助自動駕駛系統做出決策

- Tesla 的模型還使用了強化學習 (Reinforcement Learning) 技術,通過與環境交互,自動學習並優化策略,實現更為精確的駕駛決策

Google 的 LaMDA AI 模型是什麼

- LaMDA:Language Model for Dialogue Applications 是 Google 2021 年推出的自然語言處理模型,目的在幫助機器人 (Bot) 更好的理解與應對自然語言交互

- 類似於 GPT-3 都是一種基於 Transformer 架構的大型語言模型

- LaMDA 專門設計用於對話場景,讓人類與機器人更加自然、流暢的對話,甚至可以實現對抗式* 對話,進而更好的理解何應對用戶需求跟意圖

- LaMDA 的特點

- 可擴展性:可訓練成任意數量的主題、領域和語言,使用各種對話場景,例如社交、商業、醫療等

- 交互式對話:可實現更為自然、流暢、富表現力的對話

- 支持多模態:除支持文本輸入、輸出外,還能與圖像、視頻等多種媒體進行交互,實現更為豐富的對話體驗

- 隱私保護:採用聯邦學習** 的方式,將訓練數據分佈在多個設備、服務器中,避免用戶數據集中處理的風險

* 對抗式對話:Adversarial Dialogue,或稱為對抗式訓練 (Adversarial

Training),為一種機器學習技術,目的在提高 NLP 的魯棒性 (robustness)、性能

** 聯邦學習:Federal Learning

是一種機器學習技術,目的在將機器學習數據分散在多個設備或服務器上,每個設備之邀訓練自己本地數據,將訓練好的模型參數傳送給中央服務器進行聚合,在過程中無需將數據發送到中央服務器,可以避免數據洩漏隱私風險

Google LaMDA 模型示意圖

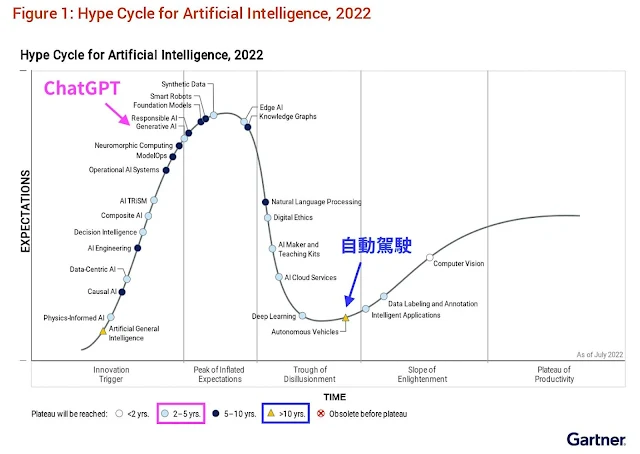

AI 商業化時程大預測

Gartner 2022 年 7 月發布了 AI Hype Cycle,預測了各種 AI 技術商業化的時程

|

| Source: Gartner |

什麼是生成式AI

什麼是ChatGPT

Bing AI

ChatGPT入門

ChatGPT懶人包

Generative AI生成式人工智慧

Google BARD

Microsoft Bing AI

Open AI ChatGPT

Tech

0 comments